PyCharm Pro 2025以AI深度协同开发为核心,重新定义了Python编程工具的天花板。相比同类产品,其杀手锏在于本地化AI代码补全(支持百亿级参数模型离线运行)、零延迟调试反馈,以及针对M系列芯片的GPU加速计算优化,实测大型数据处理任务耗时降低45%。无论是Django全栈开发、数据科学建模,还是AI算法调试,都能通过智能上下文感知实现“编码即思考”的流畅体验。

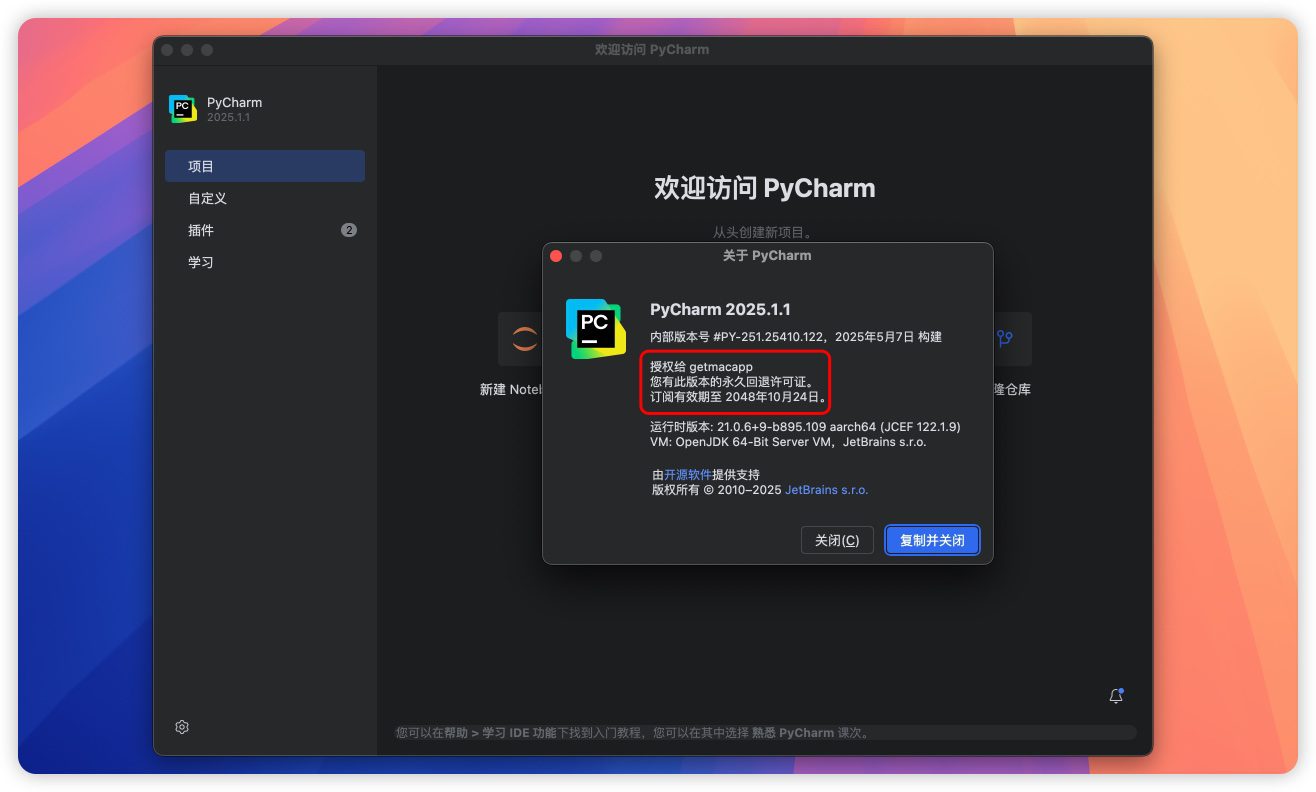

🎉官方已提供中文!该密钥支持全套JetBrains产品,一码通用激活,✅ 支持intel ✅支持M1-4,🌟后续版本也只同步这篇文章

支持的产品:II,PS,AC,DB,RM,WS,RD,CL,PC,GO,DS,DC,DPN,DM,RR,PRR,PAEMIDE,PAEM,PCWMP

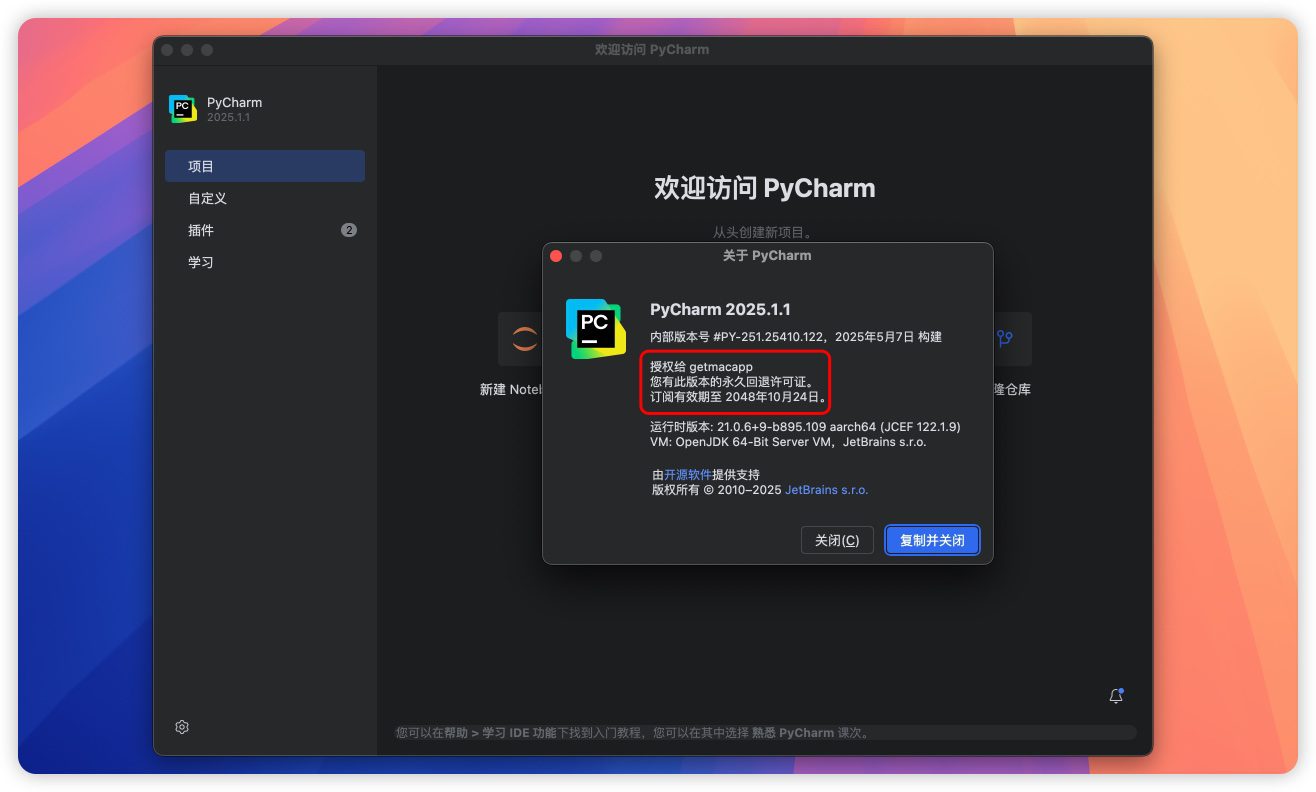

永久许可证 不需要在乎天数

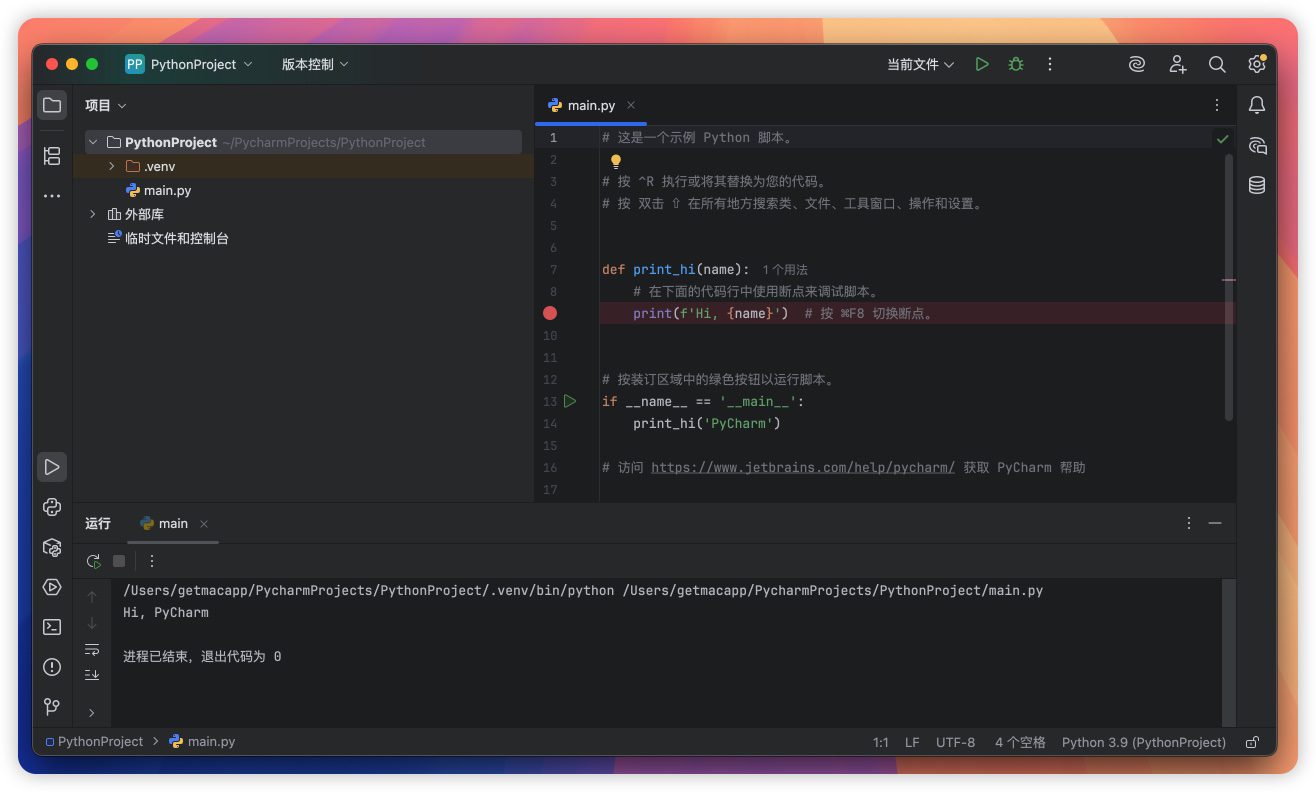

Pycharm Pro for Mac安装教程

1.打开下载好的软件包,拖动软件和JetBCrack到右边的Applications文件夹中进行安装

以前安装过JetBrains旗下的其他软件包,拖动过【JetBCrack的文件夹】则不需要再次拖动了,多此一举

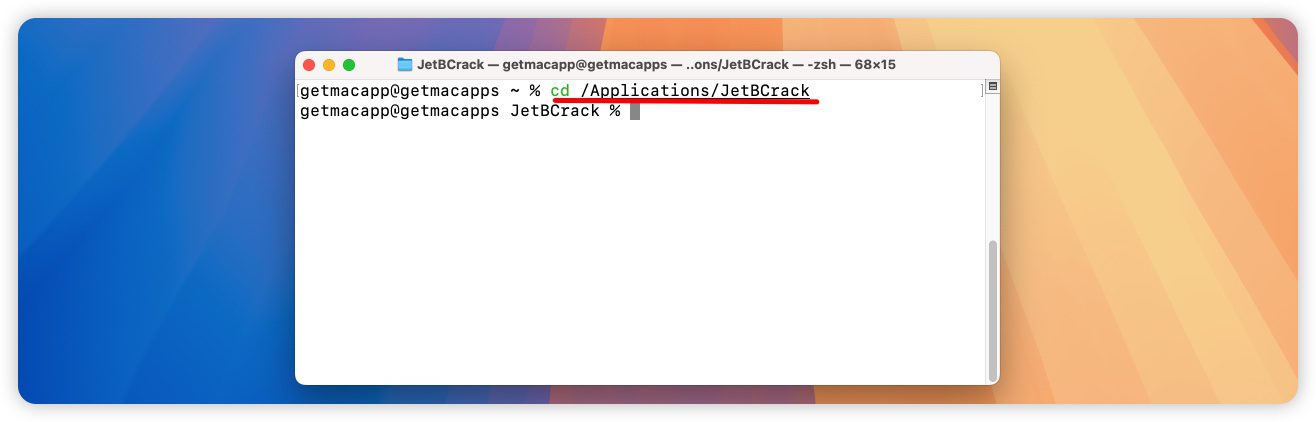

2.打开终端,复制下面命令到终端后回车

cd /Applications/JetBCrack

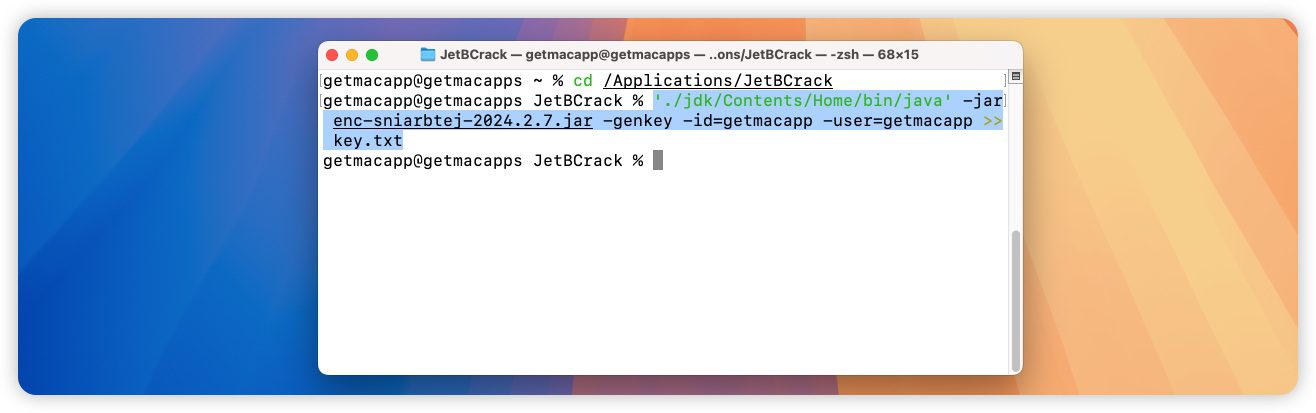

然后复制下面命令后回车!!!

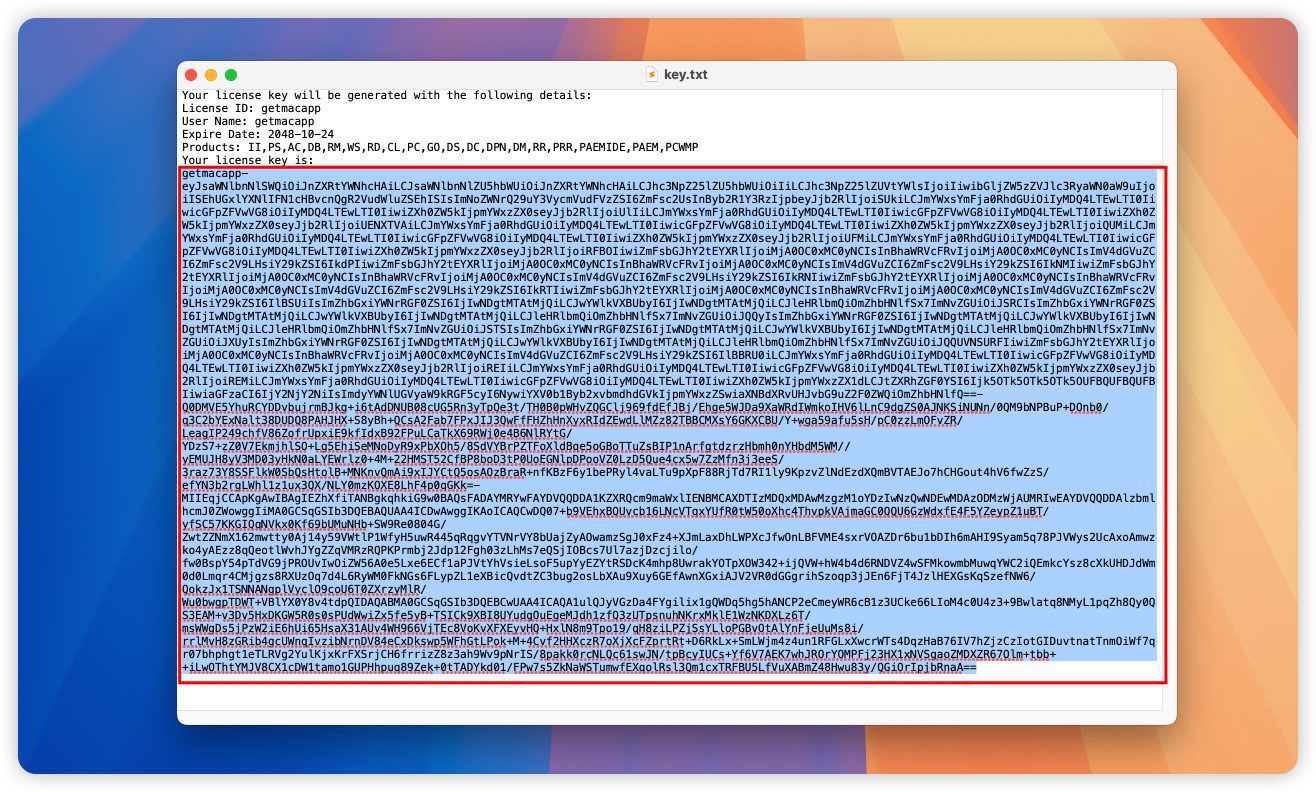

'./jdk/Contents/Home/bin/java' -jar *.jar -genkey -id=getmacapp -user=getmacapp >> key.txt

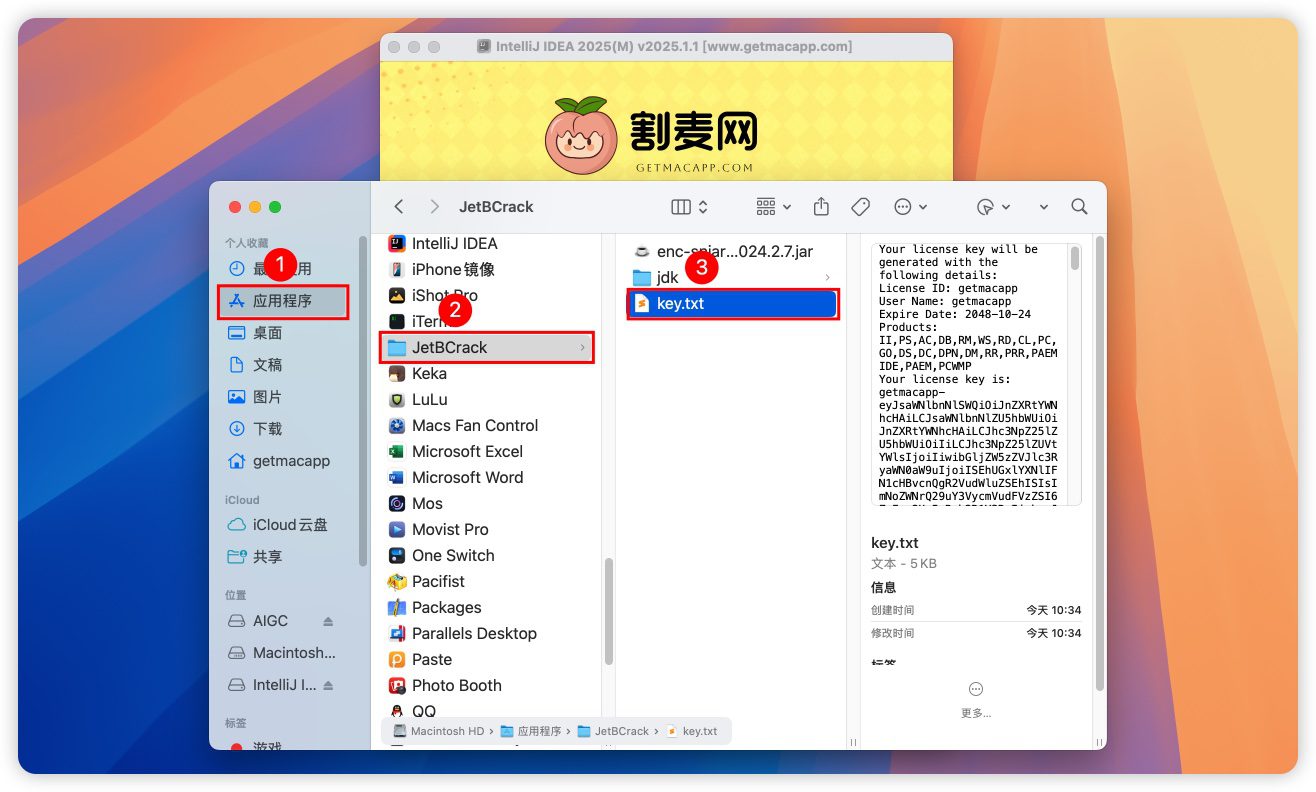

3.打开应用程序,在JetBCrack文件夹中找到key.txt文件并打开

注意:有些用户打开key.txt文件为空文本,不需要管,直接打开软件,会弹出重启软件界面,点击重启即可破解成功,不需要操作后续步骤!

⚠️该key生成一次即可,通杀后续软件,想重新生成前先删掉这个key.txt,然后重复上面步骤生成新key

复制Your license key is:后面的注册码

该密钥支持JetBrains全套,后续不需要再次生成!!!

支持的产品:II,PS,AC,DB,RM,WS,RD,CL,PC,GO,DS,DC,DPN,DM,RR,PRR,PAEMIDE,PAEM,PCWMP

4.然后打开软件,选择Activation code进入激活页面

中文设置

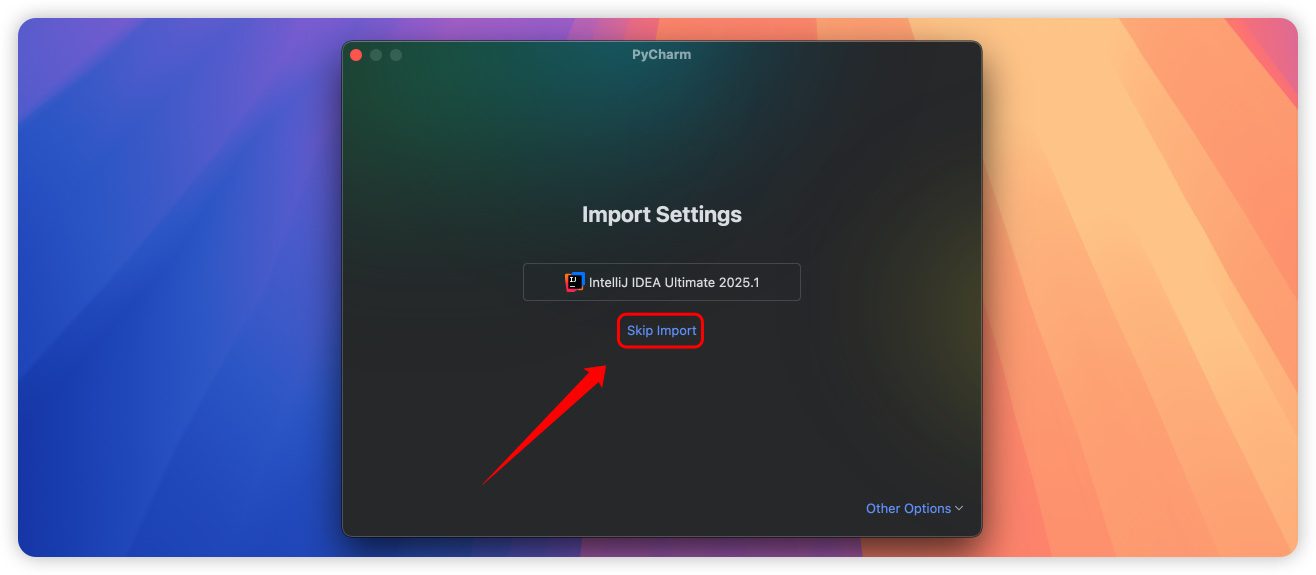

点击Skip Import跳过导入即可

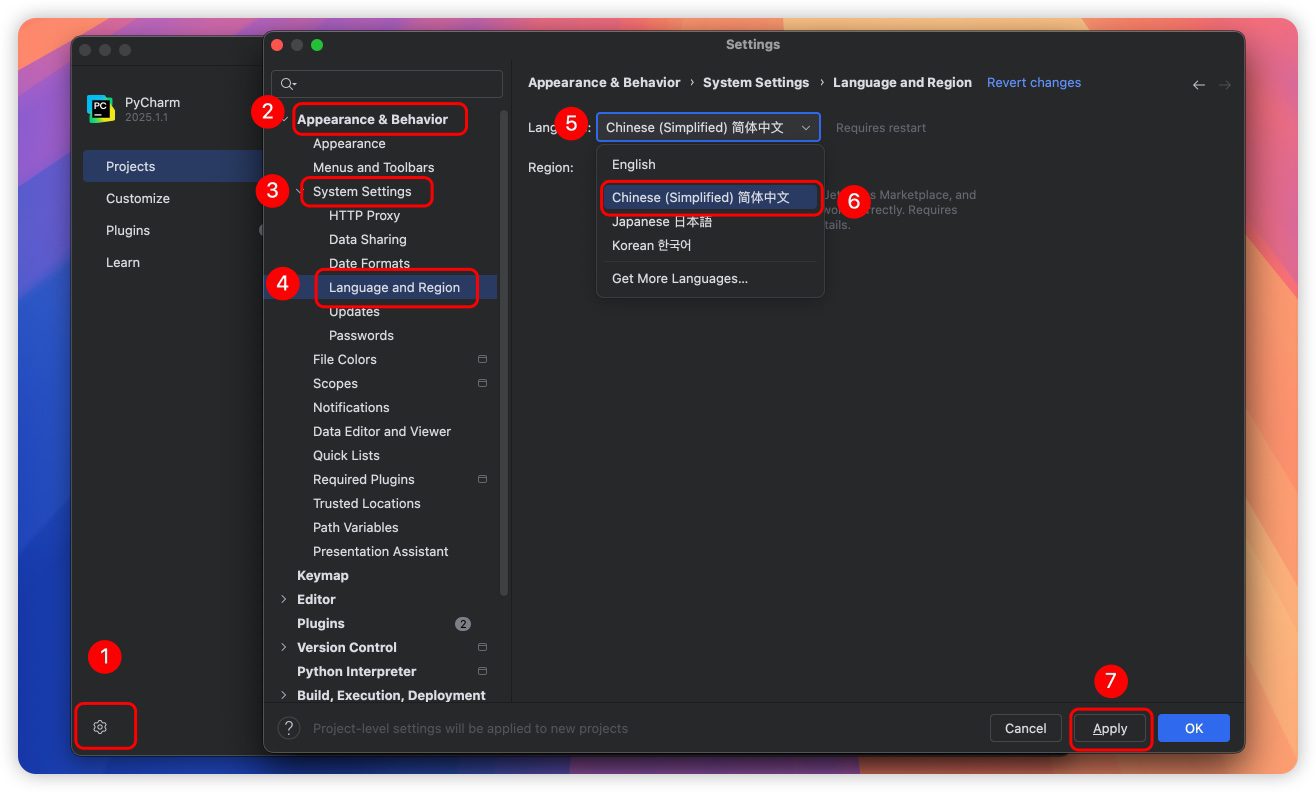

点击齿轮⚙️--Settings--Appearance&Behavior--System Settings--Language and Region--Language选择 简体中文,点击Apply

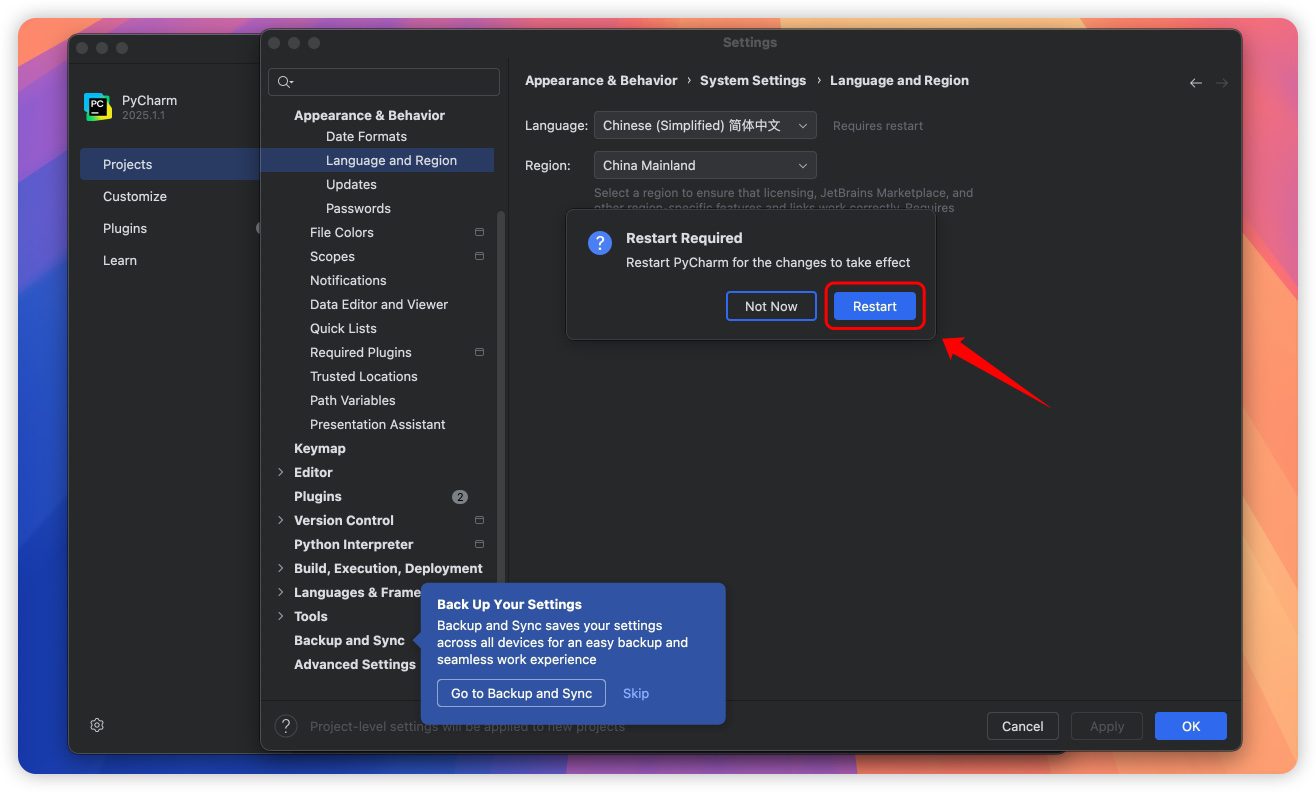

点击Restart会自动重启打开就是中文

选择付费许可证--激活码,粘贴刚刚复制的密钥,点击激活

5.破解成功

🔥功能特色

-

🤖 全场景AI渗透

-

本地化模型支持:集成CodeLlama 70B本地引擎,无网络依赖生成高质量代码片段。

-

智能错误预判:运行前标记潜在类型错误,并提供修正方案,减少调试循环。

-

-

🐞 调试模式革新

-

热重载调试:修改变量值后无需重启进程,实时观察程序行为变化。

-

Jupyter内核级调试:直接在Notebook单元内设置断点,支持PyTorch张量可视化。

-

-

⚡ 性能暴力提升

-

M3芯片专属优化:Metal API加速UI渲染,16核GPU并行处理数据索引。

-

智能内存管理:动态释放未使用索引,8GB项目加载速度提升60%。

-

-

🔗 生态深度整合

-

一键部署Docker+K8s:自动生成适合当前项目的容器化配置模板。

-

实时SQL映射:Django ORM操作同步生成可视化查询语句,支持性能分析。

-

💡场景化功能案例

-

AI模型调参优化

-

场景:调试Transformer模型时,自动标注GPU显存占用热点,推荐Batch Size优化值。

-

操作:在调试面板勾选

显存分析模式,右键高亮代码行获取优化建议。

-

-

Web全栈开发流

-

场景:开发Django REST API时,根据Swagger文档自动生成序列化器与视图类。

-

操作:在API端点注释处按

⌥⏎调出AI生成菜单,选择生成对应组件代码。

-

-

数据科学工作流

-

场景:处理20GB CSV文件时,自动切换Dask并行计算模式,内存占用降低70%。

-

操作:文件打开时勾选

大数据模式,AI自动重构Pandas代码为Dask API。

-

🛠️使用场景适配

-

机器学习研发:集成MLflow实验跟踪,支持超参数对比可视化(适合AutoML工作流)

-

远程服务器开发:SSH连接自动同步环境变量,支持远程Docker解释器配置

-

团队代码审查:AI生成Commit message建议,标记不符合PEP8规范的代码块

💡冷技巧:GPU资源榨取术

在设置→Python解释器中添加--preload参数,可让NumPy/PyTorch提前占用GPU显存,避免碎片化分配导致的性能损耗,特别适合需要反复创建张量的场景。

许可协议:《署名-非商业性使用-相同方式共享 4.0 国际 (CC BY-NC-SA 4.0)》

评论(0)